6/23金に、東海大学高輪キャンパスにて、組込みソフトウェア開発特別講義「ソフトウェアとハードウェアの複合技術によるセンサーデータの可視化と考察」を3時間話してきました。

登壇前の仕込み

登壇前の仕込みの途中経過です。

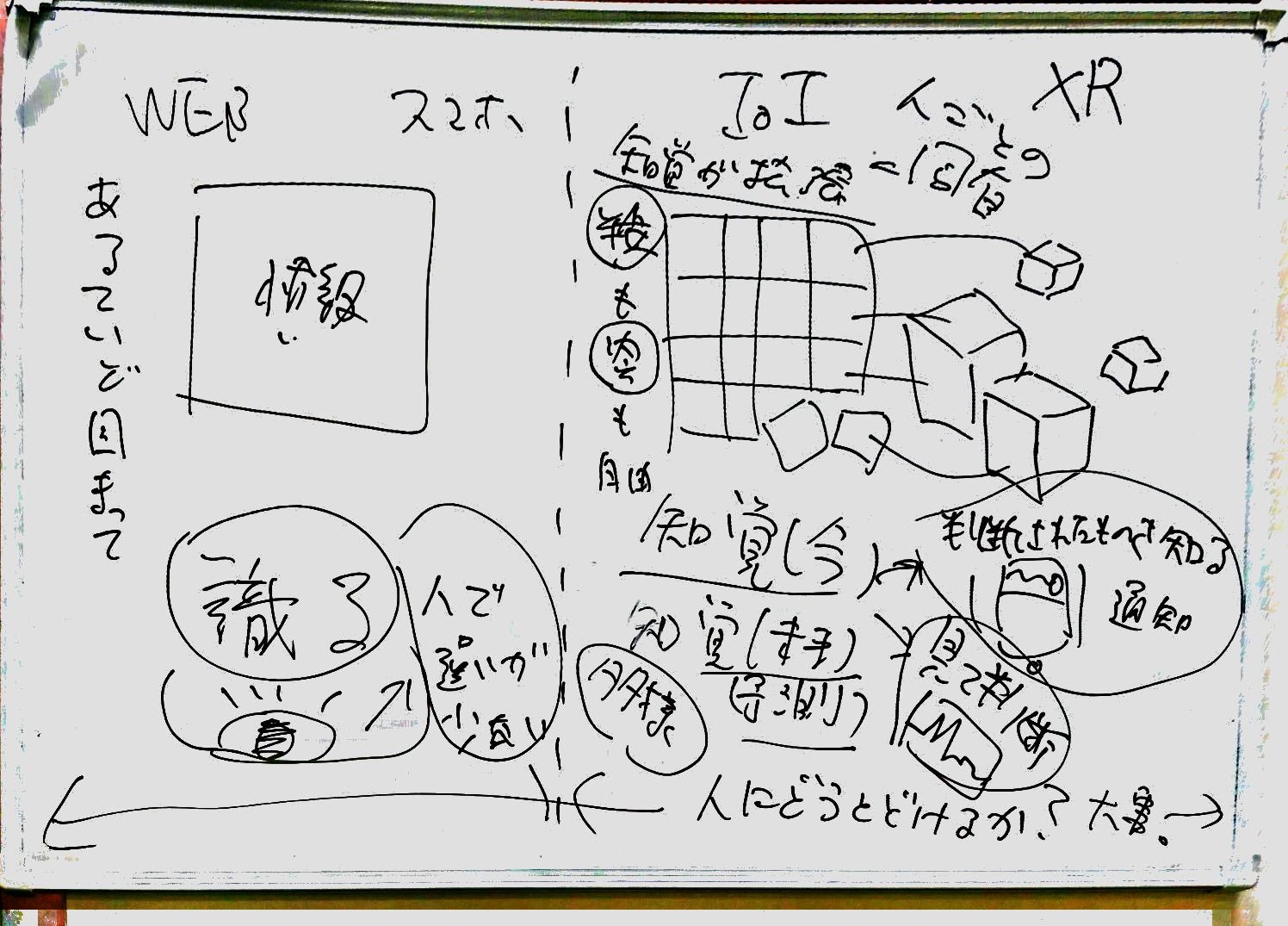

これは1ヶ月前の初動。まだまだこの段階では荒いですが、このようにホワイトボードで、まず可視化と知覚の話の片鱗が見えてはじめていますね。

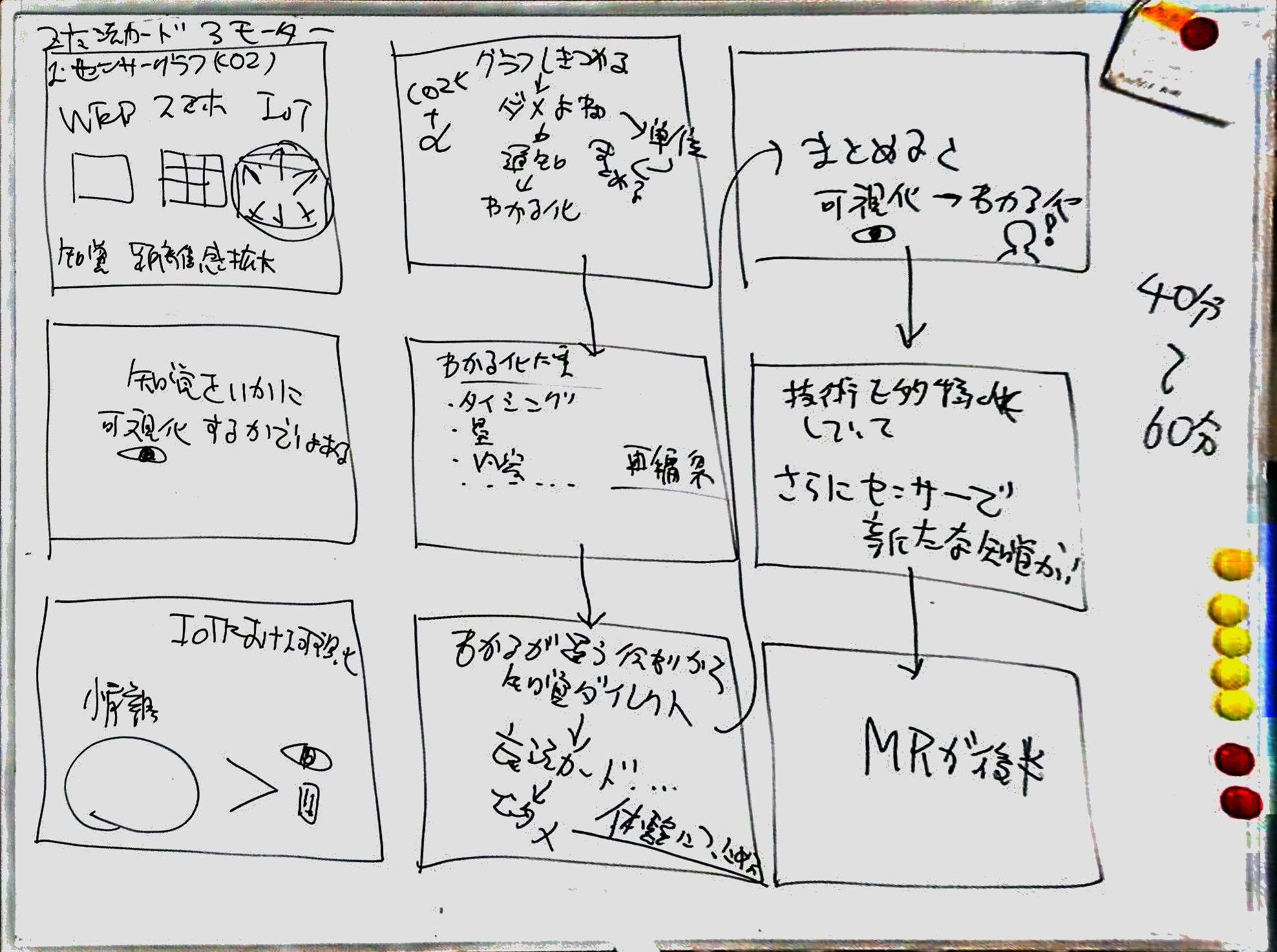

これは2週間前で一番「完成しそうで完成しない」と煮詰まっていたときです。基本構想はできましたが、これをページレイアウトに落とし込んで、スライドに書き起こせるアウトラインを決めていっています。

実際の仕上がり

シチュエーションに合わせて生徒用に調整した部分が多く、今回のスライドは公開しませんが、片鱗を。

IoTの図だったり。

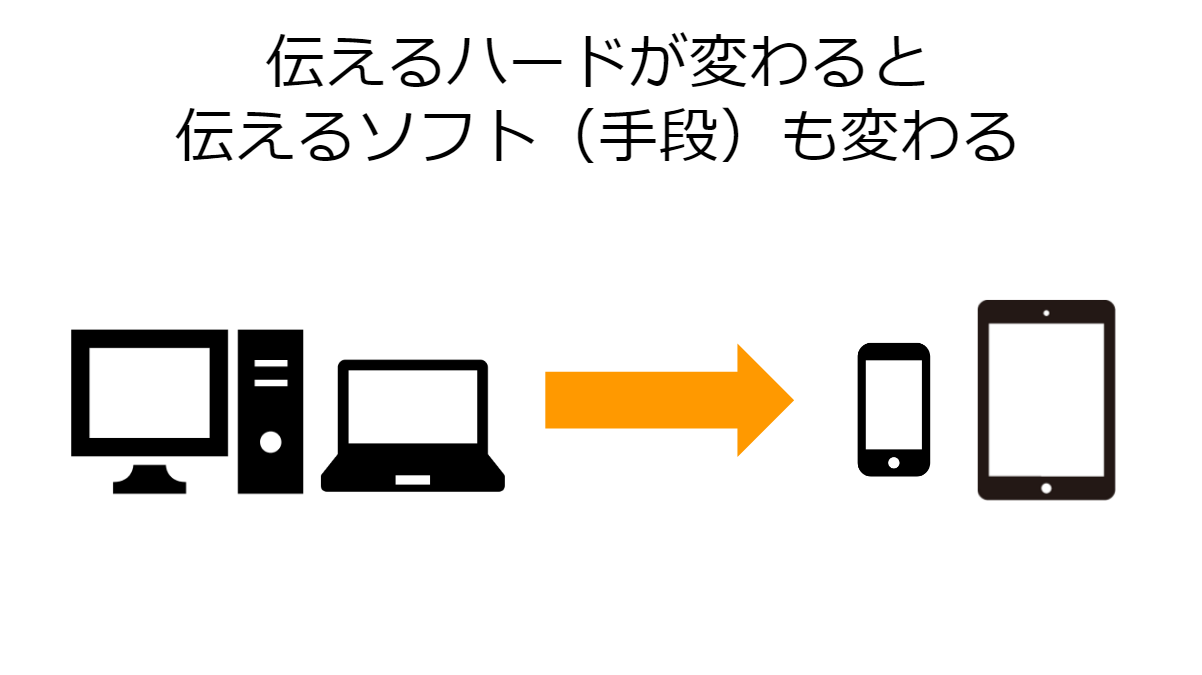

伝達手段の変遷だったり。

人と情報の距離感だったり。

こんなスライドをもとに、

- 4限 → 90分 スライド 約200P

- 従来の事柄からIoTへの変遷

- IoTの技術要素といろいろデモ

- IoTの可視化その先に気をつけるところ

- 5限 → 90分 スライド 約100P

- IoTからMixed Reality

- 今後の技術の付き合い方(私を例に)

- 質疑応答

色々と話してきました。スライドのページ数は約300P!

そして今回も、

には大変お世話になりました。

デモの雰囲気

デモについていくつか。触れておきます。

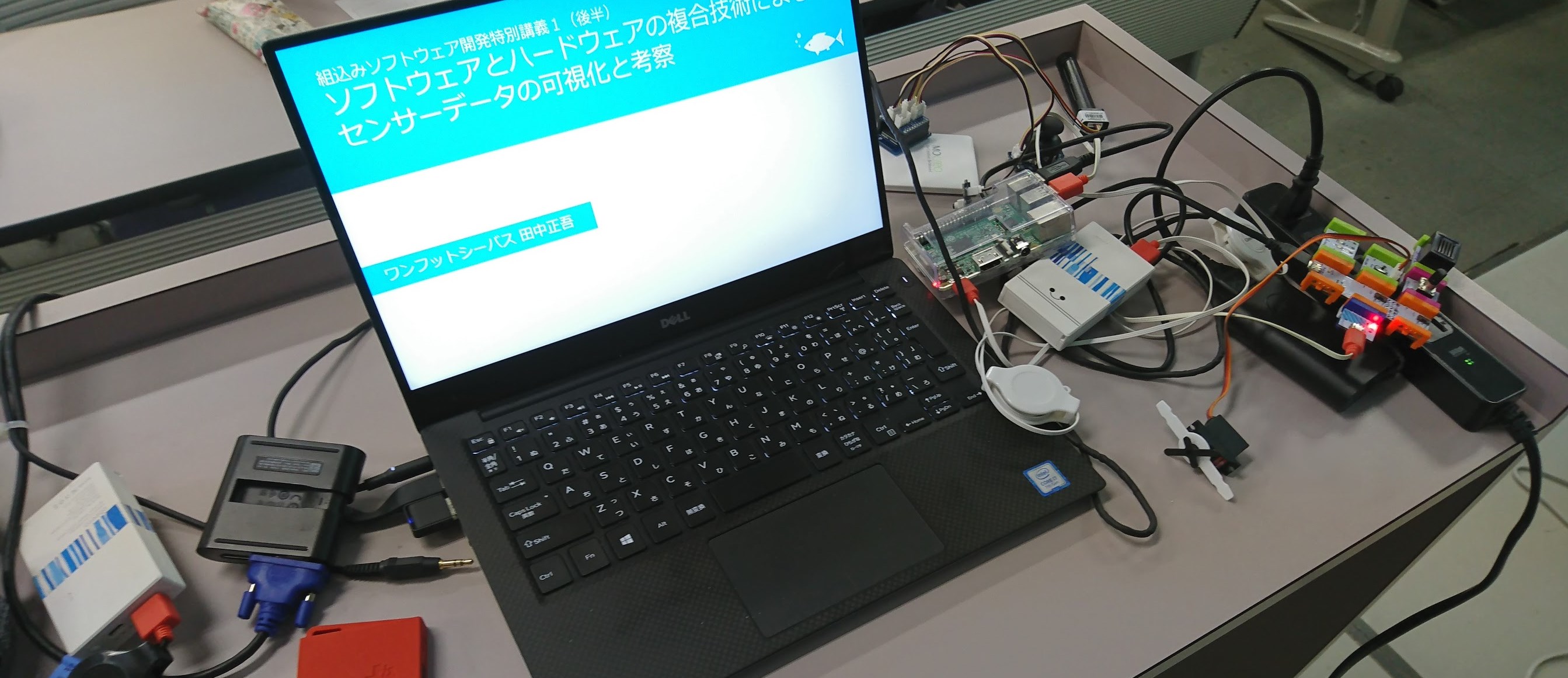

どうしてもゴチャゴチャしてしまう登壇前の登壇卓のカオス。

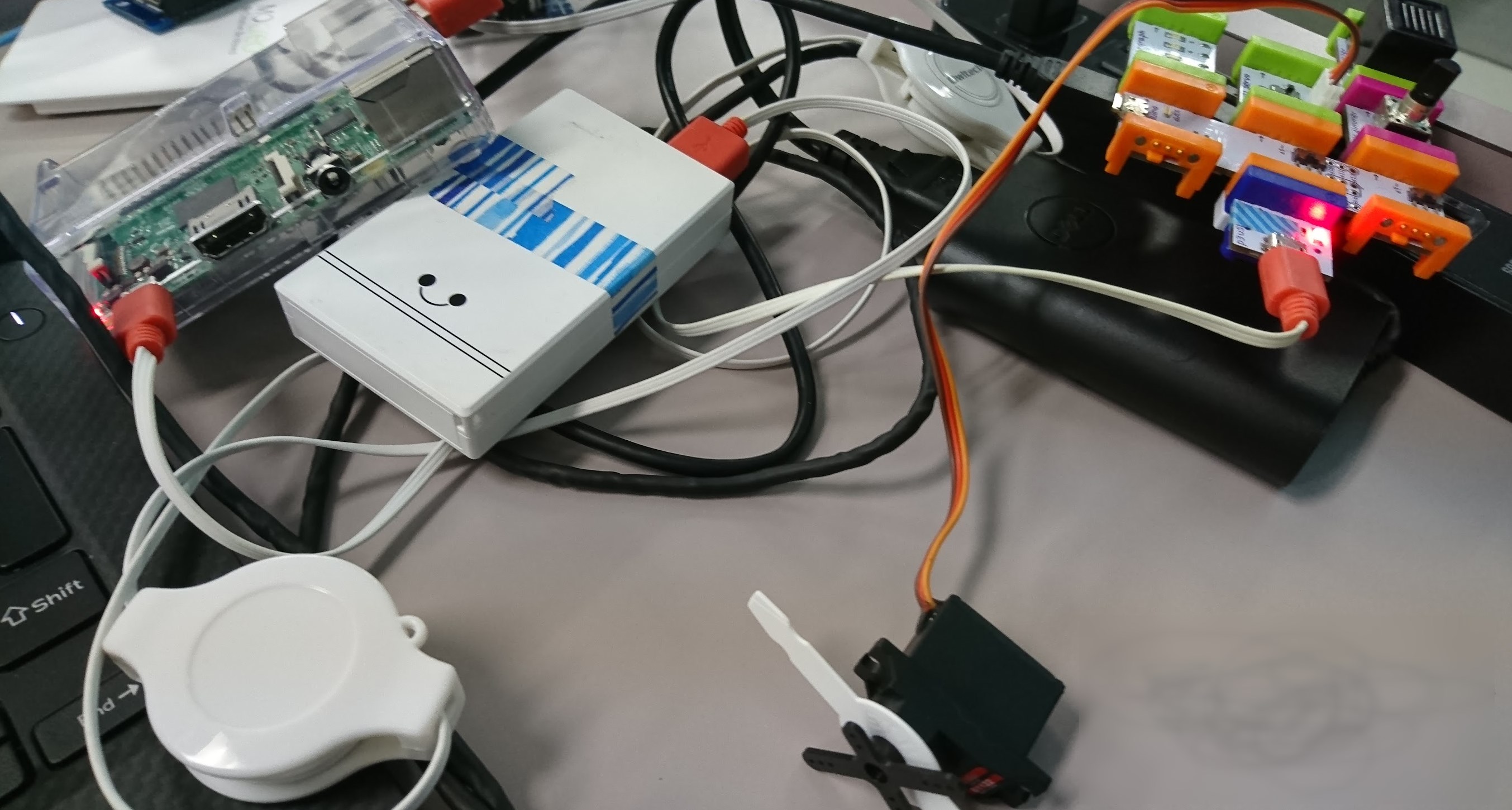

littleBitsではじめるArduinoの集大成のようなもの。

IoT連携のなかでもインターネットからの反応を現実の形に落とし込むデモでlittleBitsを使いました。生徒の反応もよく、事後に「littleBitsおもしろい」「使ってみたい!」との反応が得れました。

こちらの魔法カードネタは、以前のRaspberryPi Node-REDのカードリーダーからBluemix Node-REDのWatson Text To Speechを合わせて魔法発動ぽいカードをつくるネタの、さらにデモにしやすく進化させたもの。

クラウドでの音声生成からの「人間の優しい語りかけというユーザビリティ」や、クラウド連携による機械学習やデータ蓄積によるデータ活用などの示唆をしつつ、目の前で動いているものは、楽しげなモノとして伝えることができました。

他にも、動画でのデモを5つほど、実演デモを6つほど、無事に行うことができました。

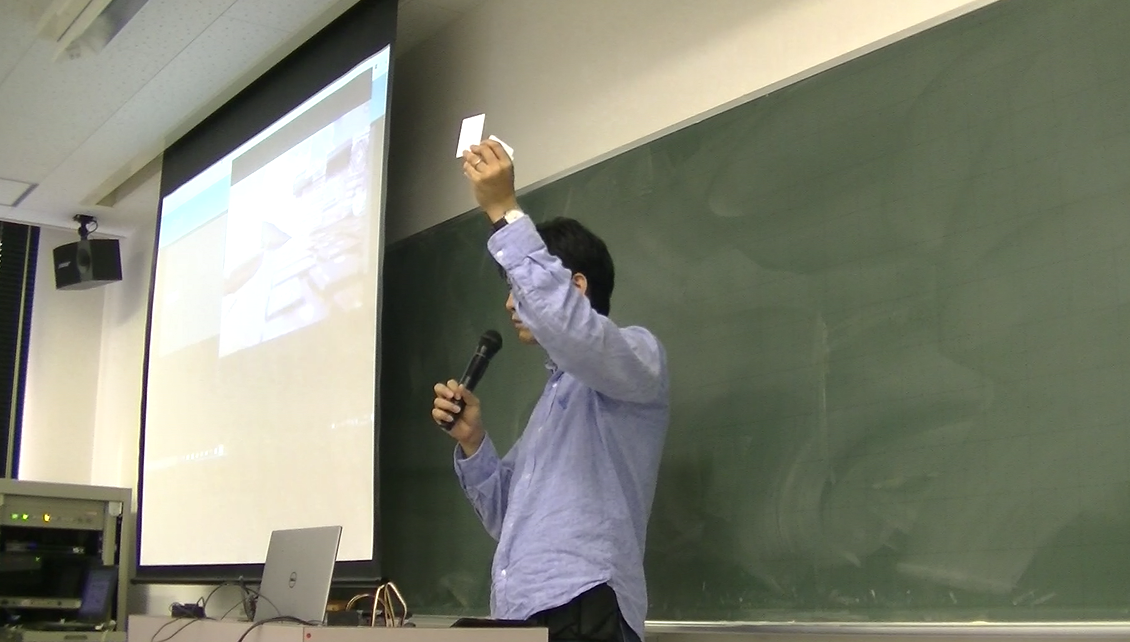

登壇風景

HoloLensとIoTを連携するの実演も行いました。組み込み系の学生さんだったので、実際の設備の制御につながる話がかなり共感をしてくれたように思います!

丁寧に説明してみたり。

デモしたり。登壇の後半はデモや実演が多くなっているのでよく画角から外れています。

登壇終わりのきれいな空。

仕込んだIoTデモ・MixedRealityデモはすべて成功して時間もいい感じに使いきりました!

今回は組み込み系の学生に、私がここしばらくやってきたことを学生向けにまとめた感じでしたが、ハードウェアの会話から引き込んで、ソフトウェアもインターネットもインターフェースも混ぜ込んだいろいろな総合力の一面を少しでも伝えられて良かったです。

ただ、3時間ぶっとおしで話すのは話す側も聞く側もパワーを使うと思うので、今度やるなら実際に手を動かしてもらったりするところも入れてみるのも良いなと思いました。

いろいろと課題もありますが、ひとまず無事に終わって良かったです。